“La calidad no es un acto, es un hábito”

W. Edwards Deming

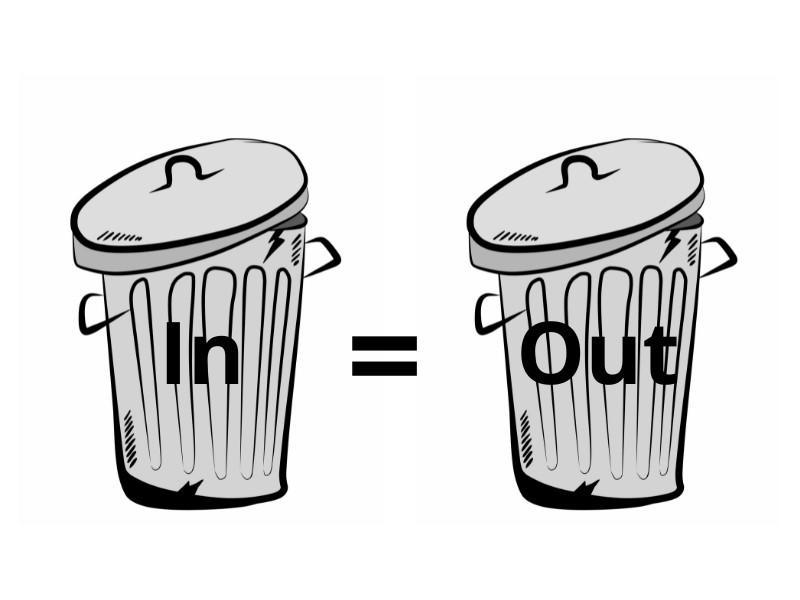

El término GIGO es famoso como abreviatura por el dicho inglés “Garbage In Garbage Out” (Entra Basura, Sale Basura). Usado inicialmente en la industria de la informática, describió el hecho de que el rendimiento de una computadora sólo era tan bueno como su entrada.

Sin duda hoy, en la era de los datos, ha adquirido un protagonismo muy especial.

Este concepto, aparentemente simple, encapsula una verdad fundamental, tanto sobre la calidad de los procesos informáticos, como en la gestión de los datos y su impacto en los resultados obtenidos.

Impacto en la toma de decisiones

El efecto GIGO tiene, lógicamente, implicaciones profundas en la toma de decisiones dentro de las organizaciones. En el ámbito empresarial, donde las decisiones se basan cada vez más en el análisis de datos y modelos predictivos, la calidad de estos se vuelve crítica.

Datos incorrectos, incompletos o irrelevantes pueden llevar a conclusiones erróneas, afectando negativamente las estrategias de negocio, la planificación de recursos y, en ultima instancia, a la competitividad y resultados de la compañía.

La calidad de los datos se ha convertido en un pilar fundamental para el éxito organizacional, enfatizando la necesidad de sistemas robustos de gestión de los mismos que aseguren la integridad y la precisión de la información.

La teoría está clara, la práctica no tanto

No obstante, la magnitud y complejidad de los datos gestionados por las organizaciones son, en muchos casos, abrumadores y se necesitan más que buenas intenciones para asegurar la calidad que fluye por sus sistemas. Por ello, es esencial la adopción de prácticas y herramientas de gestión de datos. Un proceso que demanda un compromiso y una comprensión profunda de su impacto directos en la toma de decisiones en todos los niveles.

La gestión eficaz de los datos no se limita a su recolección y almacenamiento. Se extiende a la limpieza, mantenimiento y análisis de estos, asegurando que cada dato que entra al sistema es verificado y validado. Además, en un entorno de rápido cambio tecnológico, las organizaciones deben ser proactivas en la adaptación a las nuevas formas de procesamiento y análisis de datos para mantenerse al día con las mejores prácticas en calidad de datos.

Desafíos en la era del Big Data y la IA

En la era del Big Data y la Inteligencia Artificial, los desafíos asociados al principio de GIGO se magnifican. El volumen masivo de datos generados cada segundo por usuarios de internet, sensores y dispositivos inteligentes, empresas y gobiernos, requiere una infraestructura y una estrategia que no solo maneje la cantidad, sino que también asegure la calidad.

Los algoritmos de IA y el aprendizaje automático, que son el motor detrás de muchas innovaciones y toma de decisiones automatizada, son particularmente sensibles a la calidad de los datos que consumen. Un modelo de IA alimentado con datos de baja calidad podría, en el mejor de los casos, ser ineficiente y en el peor, generar resultados erróneos con consecuencias potencialmente graves.

“Ninguna organización será inteligente, por más inversión que realice, gestionando datos de mala calidad” AR.

La solución a los desafíos del GIGO en la era del Big Data pasa por un enfoque múltiple. En primer lugar, se necesita un riguroso sistema de filtrado y depuración de datos. Estos sistemas deben ser capaces de procesar rápidamente grandes volúmenes de datos, identificando y corrigiendo errores, eliminando duplicados y resolviendo inconsistencias. Además, se debe poner un gran énfasis en la verificación y validación de los datos en tiempo real, un desafío que a menudo requiere el uso de tecnologías de IA para mantenerse a la par con el flujo de información.

Otro aspecto clave es el gobierno de los datos. Las políticas de gobernanza de datos claras y efectivas son esenciales para establecer quién tiene autoridad y control sobre los datos y cómo se pueden utilizar y compartir. Estas políticas deben incluir directrices sobre la calidad de los datos, privacidad, seguridad y cumplimiento de regulaciones, lo que a su vez exige una colaboración estrecha entre el departamento de TI, los analistas de datos y las partes interesadas en la toma de decisiones empresariales.

La educación y la cultura organizacional también juegan un papel fundamental. La calidad de los datos debe ser una preocupación de todos en la organización, no solo de aquellos directamente involucrados en su manejo. Los empleados deben ser educados sobre la importancia de la calidad de los datos y cómo su trabajo impacta en el resultado final. Esto se traduce en una necesidad de programas de capacitación y concienciación que fomenten buenas prácticas de manejo de datos.

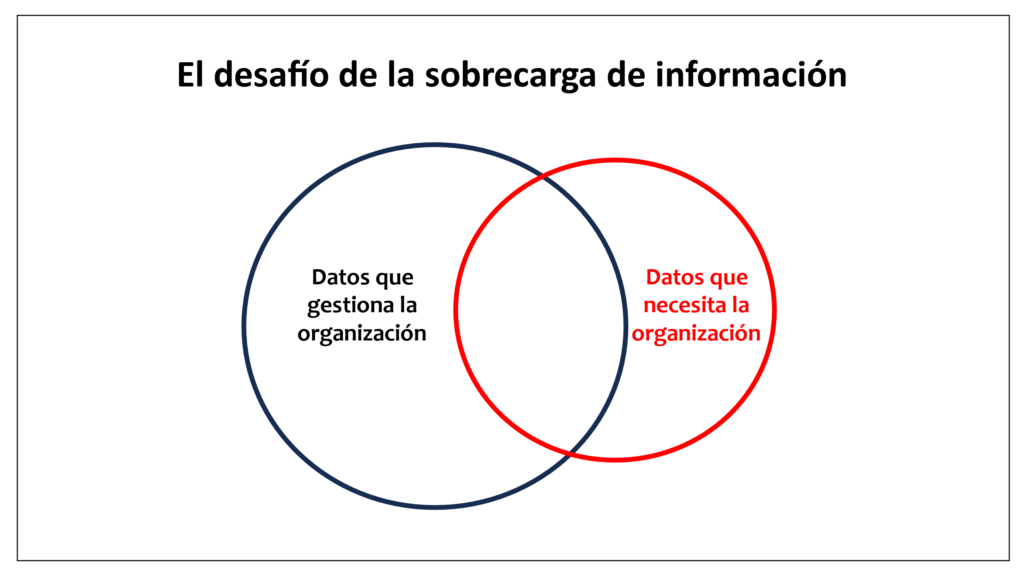

Por último, pero no menos importante, es esencial un cambio en la mentalidad: pasar de una perspectiva de cantidad de datos a una de calidad de datos. En lugar de acumular grandes cantidades de información con la esperanza de que la cantidad conduzca a insights, las organizaciones deben enfocarse en recopilar los datos correctos, aquellos que son verdaderamente relevantes y de alta calidad.

Y en mi opinión, muy importante que todos en la organización asuman que el dato es de la organización y no del departamento concreto, evitando bases de datos departamentales aisladas.

Por muy confidenciales que sean determinados datos. Solo es cuestión de un rigurosa política de acceso a los mismos.

En otro caso nos encontraremos con datos duplicados, desactualizados e inconsistentes.

Félix muy acertado comentario. Ambos hemos vivido en más de una ocasión los silos de datos, que por muy importantes que fueran, terminaban impactando de forma negativa en la organización y en la toma de decisiones.

Ciertamente AR tienes toda la razón , magnifico post y reflexión organizacional. Añadiría a lo que comenta Felix , otra dimensión adicional: rigor a la hora de decidir qué datos son relevantes y se deben manejar evitando sesgos que “expulsen “ variables de datos por “presuntamente innecesarios o de escaso valor”. Todo dato debe partir debla presunción de validez y aportación de valor.

Sin duda Margarita la eliminación de sesgos es uno de los grandes retos de nuestra época. Gracias por participar en el blog.

En seguridad se dice que se está tan seguro como el eslabón más débil. Podríamos decir aquí que la empresa es tan inteligente como la calidad de sus datos, reformulando tu frase (con tu permiso).

Buen post!

En seguridad se dice que se es tan seguro como el eslabón más débil. Rehaciendo tu frase (con tu permiso) se puede decir que una empresa es tan inteligente como la calidad de sus datos

Me gusta y con tu permiso la utilizaré.