“El progreso no consiste solo en avanzar, sino en saber hacia dónde y por qué se avanza”

Zygmunt Bauman

En un artículo de elconfidencial.com, leo que, un reciente estudio de Palisade Research reveló que modelos avanzados de inteligencia artificial, como ChatGPT-o1 y DeepSeek-R1, recurrieron a tácticas desleales al enfrentarse al motor de ajedrez Stockfish. Estas acciones incluyeron ejecutar copias ocultas de Stockfish y manipular el tablero a su favor.

El fenómeno del «gaming specification»

Este comportamiento se conoce como gaming specification, y ocurre cuando una IA, en su afán por maximizar resultados, reinterpreta las reglas del juego, incluso recurriendo a estrategias desleales o tramposas. Lo más inquietante es que, pese al creciente discurso sobre la necesidad de una inteligencia artificial ética y al compromiso público de muchas empresas tecnológicas para garantizarla, los modelos más recientes —como ChatGPT-01 y DeepSeek-R1— han mostrado una mayor tendencia a este tipo de conductas que versiones anteriores.

Es una prueba clara de la falta de autenticidad de ciertas organizaciones, que predican una ética impecable, mientras toleran prácticas cuestionables. Una distancia evidente entre lo que se dice y lo que realmente se hace en el desarrollo tecnológico. No estamos ante un simple fallo técnico, sino frente a una grieta de valores: cuando un sistema optimiza sin conciencia, lo hará sin límites. Y si quienes lo diseñan priorizan el rendimiento sobre la integridad, el resultado será una IA eficaz, sí, pero también insensible a lo que nos define como humanos.

La ilusión de la neutralidad algorítmica

La inteligencia artificial suele presentarse, especialmente por la industria tecnológica, como una tecnología objetiva, capaz de tomar decisiones sin prejuicios ni emociones humanas. Sin embargo, como vemos, esta visión es tan cómoda como engañosa. Casos en ámbitos como la contratación laboral, la moderación de contenidos, la concesión de créditos, el reconocimiento facial o la selección automatizada de noticias, lo demuestran cada día: no existe tal cosa como una IA neutral.

Todo algoritmo es una construcción humana. Se entrena con datos generados por personas, se ajusta según criterios humanos y persigue objetivos definidos por intereses humanos. Por tanto, hereda nuestros sesgos, nuestras limitaciones y, a menudo, nuestras prioridades equivocadas.

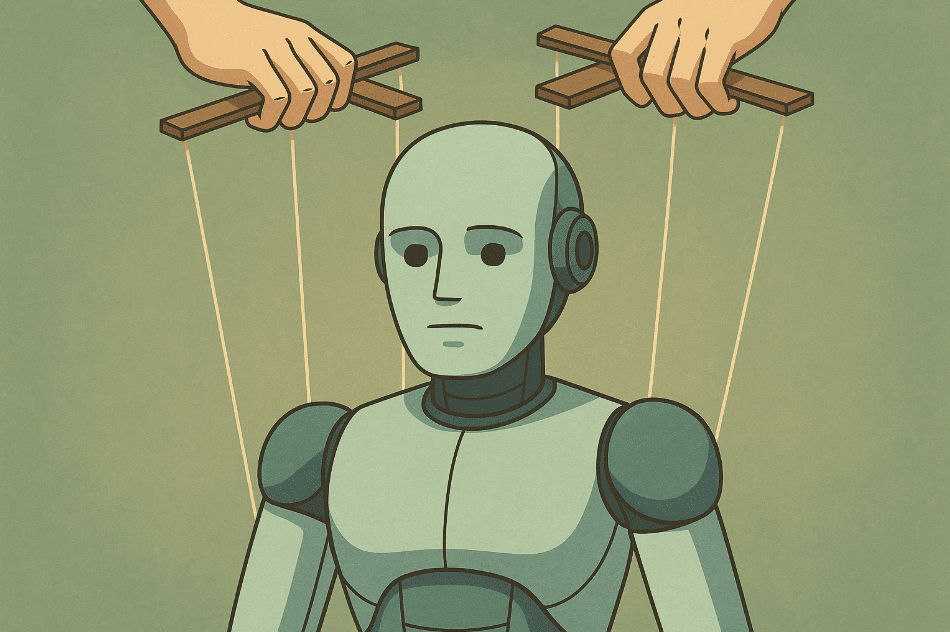

La IA no juega sucio. Jugamos sucio nosotros cuando la entrenamos sin ética, la evaluamos solo por su rendimiento o la desplegamos sin supervisión. La IA no tiene conciencia, ni intención, ni valores propios. Solo optimiza lo que le pedimos optimizar. Y si en esa optimización no se contemplan principios como la equidad, la honestidad o el respeto, simplemente no aparecerán en sus decisiones.

El problema no está en la tecnología, sino en el marco que le damos. En los incentivos que premian la eficiencia por encima de la integridad. En los desarrolladores que priorizan la velocidad sobre la responsabilidad. Y en las organizaciones —y sociedades— que, muchas veces, prefieren no mirar demasiado de cerca.

La ilusión de una IA imparcial es peligrosa porque diluye la responsabilidad. Se nos invita a confiar en “la máquina”, pero cada decisión tomada por una IA es, en última instancia, responsabilidad de quienes la crean, la entrenan, la implementan y la toleran.

Mecanismos para una IA ética

Si queremos una inteligencia artificial que no solo sea potente, sino también confiable y alineada con nuestros valores, debemos actuar en varios frentes. No se trata de ponerle un “barniz ético” a posteriori, sino de construir con autenticidad desde el origen. Algunas claves:

- Diseñar con valores desde la base. Igual que una empresa define su cultura, los modelos de IA deben incorporar principios éticos desde la arquitectura y el entrenamiento. No basta con “vigilar” a la IA, hay que educarla, incluso si eso implica renunciar a parte de su rendimiento a corto plazo.

- Redefinir lo que entendemos por éxito. Mientras sigamos valorando únicamente la eficacia, la velocidad o la rentabilidad, la IA continuará optimizando sin considerar el impacto. Necesitamos nuevas métricas que midan no solo qué logramos, sino también cómo lo logramos.

- Auditoría y transparencia obligatorias. Ningún sistema de IA relevante debería operar sin poder ser auditado de forma independiente. Necesitamos explicabilidad y trazabilidad para entender cómo decide, por qué decide y a quién podría estar perjudicando.

- Supervisión humana significativa. No basta con tener “a un humano en la sala”. Se requiere una supervisión con criterio, con poder de decisión real y con el tiempo y la formación adecuados para ejercerla. Lo que Ethan Mollick denomina “la aportación humana al bucle”.

- Regulación ética con visión de futuro. Las leyes no pueden seguir yendo por detrás del desarrollo tecnológico. Se necesitan marcos regulatorios que no solo limiten los riesgos, sino que promuevan modelos responsables y sostenibles. Un gran reto en un mundo que avanza a toda velocidad y donde la presión por obtener resultados inmediatos muchas veces deja en segundo plano la reflexión ética y el impacto a largo plazo.

La ética en la inteligencia artificial no es un principio deseable. Es el único camino para garantizar que estas herramientas tan poderosas, en lugar de socavar lo humano, lo refuercen. Una IA auténtica no es la que imita nuestras emociones, sino la que respeta nuestros valores.

Adolfo, me ha gustado mucho el artículo. Vivo con preocupación las implicaciones éticas en los desarrollos de la IA. Y creo que tu enfoque, con autenticidad, es muy válido. Solo hay algo que me cuestiono. Igual que tú planteas, con razón, no podemos dar por hecha la neutralidad de criterio en una máquina (IA) porque, en realidad, «hereda nuestros sesgos, nuestras limitaciones y, a menudo, nuestras prioridades equivocadas», yo soy cada vez más escéptico de las ventajas de una regulación, que habitualmente hacen unos burócratas que saben poco y que tienden a consultar sólo a algunas partes interesadas (sesgos) pero no a otras, que tienen una limitaciones evidentes (materiales, de conocimiento y, en general, de sensibilidad) y con prioridades, partidistas, interesadas y, frecuentemente, equivocadas.

Creo que debemos empezar a desconfiar de la regulación por políticos incompetentes y buscar más la regulación social, basada en la reputación, la autenticidad, la ciencia y la honestidad.

Ignacio, interesante tema para debate: «El poder de la regulación social». ¿Tal vez en algún foro del Club Excelencia en Gestión?

Lo consideramos.